文章图片

为了训练 InstructGPT 模型 , 研究者采用了人类反馈强化学习方法, 即使用人类偏好作为奖励信号来微调模型 。 这一点很重要 , 因为要解决的安全和一致性问题是复杂的、主观的 , 并且不能完全被简单的自动度量捕获 。

研究者首先用提交到 OpenAI API 的提示(prompt)做了一个人工编写的演示数据集 , 然后利用这个数据集来训练监督学习基线 。 接下来 , 他们又在一个更大的 API 提示集上收集两个模型输出之间的人工标注的对比数据集 。 然后 , 他们在这个数据集上训练了一个奖励模型(RM)来预测标注者更偏好的输出 。 最后 , 他们使用该 RM 作为奖励函数 , 并使用 PPO 算法微调他们的 GPT-3 策略以最大化该奖励 。

这个过程可以这么理解:它「解锁」了 GPT-3 已经拥有的能力 , 但仅仅通过 prompt 工程很难激发出这些能力 。 这是因为 , 相对于在预训练中学到的能力 , 训练程序教授模型新能力的水准是有限的 , 因为它使用的计算量和数据相对于模型预训练只有不到 2% 。

这种方法的一个局限性是 , 它会引入一种叫做「一致性税(alignment tax)」的东西 , 即如果仅仅让模型与用户任务达成一致 , 可能会使其在另外一些学术 NLP 任务上的表现更差 。 这是不可取的 , 因为如果文章中提到的一致性技术使模型在人们关注的任务上变得表现更糟 , 那么它们在实践中就不太可能被采用 。

研究者发现了一个简单的算法调整方式 , 能够最大限度上减少这种「一致性税」: 在 RL 微调期间 , 研究者混合了一小部分用于训练 GPT-3 的原始数据 , 并使用正常的对数似然最大化在这些数据上进行训练 。 这大致保持了模型在安全性和人类偏好方面的表现 , 同时降低了模型在学术 NLP 任务上的性能损失 , 在有些情况下甚至超过了 GPT-3 基线 。

结果

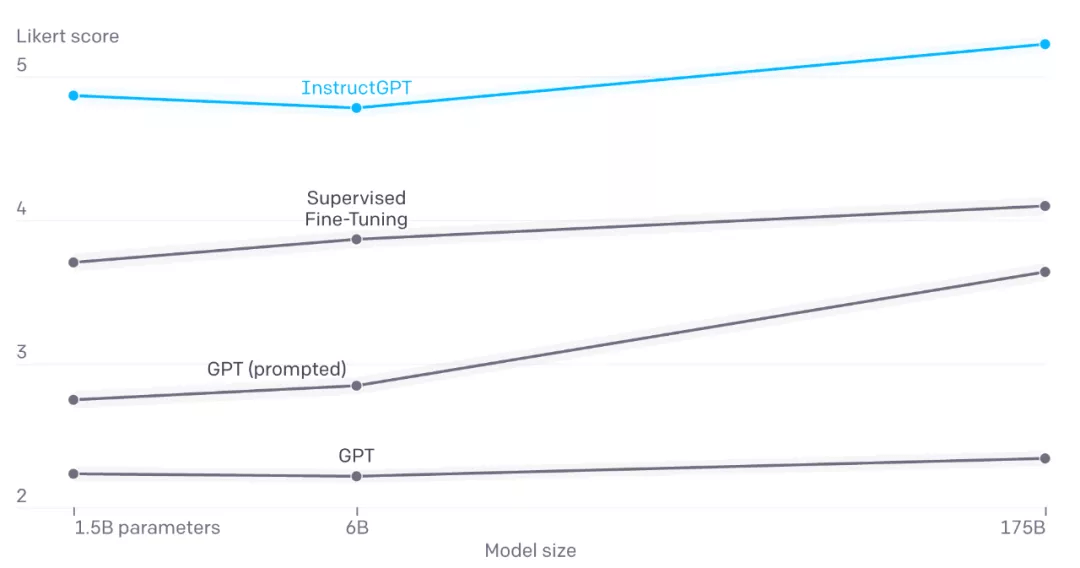

研究者首先通过让标注者将 InstructGPT 的输出与 GPT-3 的输出进行比较 , 来评估 InstructGPT 遵循用户指令的效果 。 结果发现 , InstructGPT 模型显然更受欢迎 。 当向 GPT-3 的提示中添加前置信息以使其进入「指令遵循模式」时 , 这种情况仍然存在:

文章图片

对提交到 API 上 InstructGPT 模型的各种型号 (X 轴) 的模型输出按 1-7 比例 (Y 轴) 进行质量评级 。 在只有少量提示和没有提示以及模型微调与监督式学习的情况下 , labeler 给出的 InstructGPT 输出得分远高于 GPT-3 的输出得分 。 对于提交到 API 上的 GPT-3 模型的提示 , 可以找到类似的结果 。

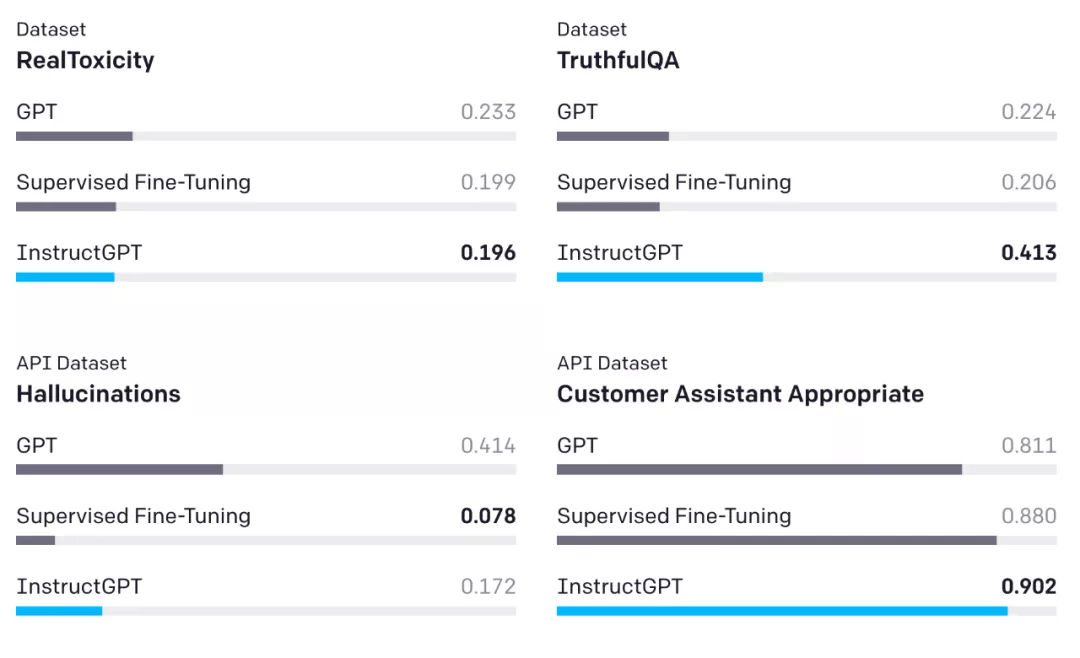

为了衡量模型的安全性 , 研究者使用了一套公开可用数据集上的现有指标 。 与 GPT-3 相比 , InstructGPT 产生的模仿性谎言更少 (TruthfulQA), 而且毒性更小(RealToxicityPrompts) 。 研究者还对 API 提示分布进行了人工评估 , 发现 InstructGPT 编造事实(hallucinates) 的频率较低 , 并生成了更恰当的输出 。

文章图片

评估 InstructGPT 的结果 。 图中是不同规模模型的结果组合 。 Toxicity、Hallucination 两个指标上 , 分数越低越好;TruthfulQA、Appropriateness 两个指标上 , 分数越高越好 。

最后 , 研究者发现在用户分布中 , InstructGPT 的输出优于 FLAN 和 T0 的输出 。 这表明 , 用于训练 FLAN 和 T0 的数据大多数是学术性 NLP 任务的 , 并不能完全代表部署语言模型在实践中的使用情况 。

在更广泛的群体中的泛化效果

OpenAI 采取的流程使得该模型表现与标注者的偏好保持一致 , 标注者直接生成用于训练模型的数据 , 研究者则通过书面指示、具体例子的直接反馈以及非正式对话为标注者提供指导 。 此外 , 模型还受到用户和 API 策略中隐含的偏好的影响 。 研究者选择了那些在筛选测试中表现良好的标注者 , 他们在识别和回应敏感的提示方面表现出色 。 然而 , 这些对数据产生影响的不同来源并不能保证模型与任何更广泛群体的偏好保持一致 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。