解决Transformer训练难题,微软研究院把Transformer干到了1000层( 四 )

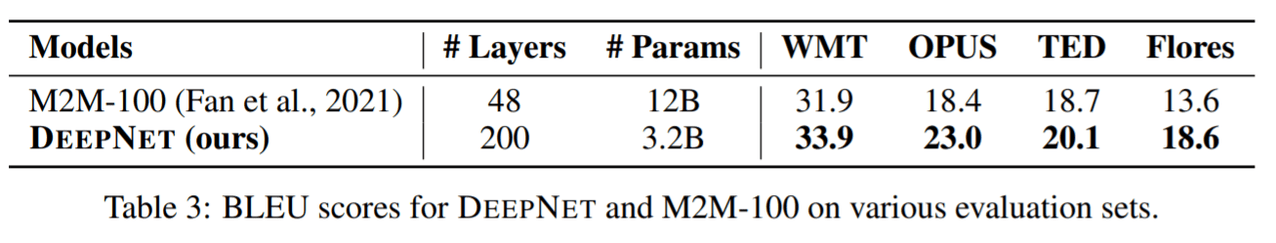

该研究将 DeepNet 与SOTA多语 NMT 模型 M2M-100进行了比较 。 M2M-100 有一个 24 层的编码器、一个 24 层的解码器和 4,096 个隐藏大小 , 从而产生高达 12B 的参数 。 与M2M-100相比 , DeepNet深而窄 , 参数只有3.2B 。

在 M2M-100 之后 , 该研究在几个多语言翻译评估数据集上评估模型 , 包括 WMT、OPUS 、TED、 Flores 。 WMT的语言对是以英语为中心的 。 包括英语在内的10种语言 , 其中大部分是高资源语言 。 对于 OPUS 数据集 , 该研究从包含 30 个评估对的测试集中选择非英语方向 。 TED评估集有28种语言和756个方向 , 数据来自口语领域 。Flores 数据集包含 102 种语言之间的所有翻译对 。 该研究使用涵盖 M2M-100 和 DeepNet 支持的语言的子集 , 产生 87 种语言和 7,482 个翻译方向 。

表 3 报告了结果 , 为了公平比较 , 该研究使用与基线相同的评估方法 。 结果表明 DeepNet 在所有评估数据集上的性能都明显优于 M2M-100 , 表明深化模型是提高 NMT 模型质量的一个非常有前景的方向 。

文章图片

【解决Transformer训练难题,微软研究院把Transformer干到了1000层】感兴趣的读者可阅读论文原文 , 了解更多细节内容 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。