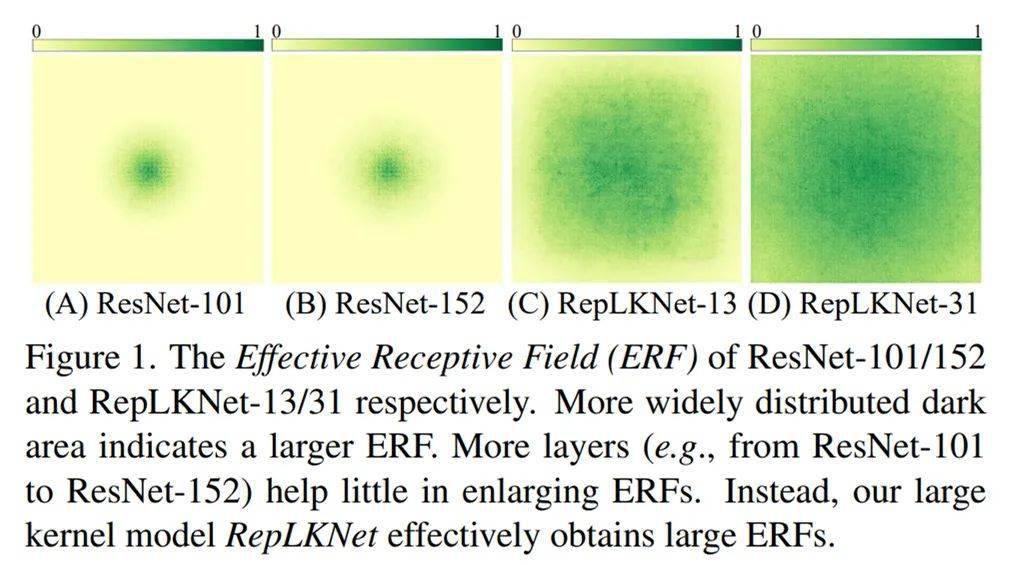

3. 基于超大卷积核 , 对有效感受野、shape bias(模型做决定的时候到底是看物体的形状还是看局部的纹理?)、Transformers 之所以性能强悍的原因等话题的讨论和分析 。 我们发现 , ResNet-152 等传统深层小 kernel 模型的有效感受野其实不大 , 大 kernel 模型不但有效感受野更大而且更像人类(shape bias 高) , Transformer 可能关键在于大 kernel 而不在于 self-attention 的具体形式 。

例如 , 下图 1 分别表示 ResNet-101、ResNet-152、全为 13x13 的 RepLKNet、kernel 大到 31x31 的 RepLKNet 的有效感受野 , 可见较浅的大 kernel 模型的有效感受野非常大 。

文章图片

有效感受野 。

C. 提出的架构 RepLKNet 效果如何?

1. ImageNet 上 , 与 Swin-Base 相当 。 在额外数据训练下 , 超大量级模型最高达到 87.8% 的正确率 。 超大卷积核本来不是为刷 ImageNet 设计的 , 这个点数也算是可以让人满意 。

2. Cityscapes 语义分割上 , 仅用 ImageNet-1K pretrain 的 RepLKNet-Base , 甚至超过了 ImageNet-22K pretrain 的 Swin-Large 。 这是跨模型量级、跨数据量级的超越 。

3. ADE20K 语义分割上 , ImageNet-1K pretrain 的模型大幅超过 ResNet、ResNeSt 等小 kernel 传统 CNN 。 Base 级别模型显著超过 Swin , Large 模型与 Swin 相当 。 超大量级模型达到 56% 的 mIoU 。

4. COCO 目标检测上 , 大幅超过同量级的传统模型 ResNeXt-101(超了 4.4 的 mAP) , 与 Swin 相当 , 在超大量级上达到 55.5% 的 mAP 。

下面是详细介绍 。

初衷:我们为什么需要超大 kernel size?

在当今这个时代 , 我们再去研究听起来就很复古的大 kernel , 是为什么呢?

1. 复兴被「错杀」的设计元素 , 为大 kernel 正名 。 在历史上 , AlexNet 曾经用过 11x11 卷积 , 但在 VGG 出现后 , 大 kernel 逐渐被淘汰了 , 这标志着从浅而 kernel 大到深而 kernel 小的模型设计范式的转变 。 这一转变的原因包括大家发现大 kernel 的效率差(卷积的参数量和计算量与 kernel size 的平方成正比)、加大 kernel size 反而精度变差等 。 但是时代变了 , 在历史上不 work 的大 kernel , 在现代技术的加持下能不能 work 呢?

2. 克服传统的深层小 kernel 的 CNN 的固有缺陷 。 我们曾经相信大 kernel 可以用若干小 kernel 来替换 , 比如一个 7x7 可以换成三个 3x3 , 这样速度更快(3x3x3< 1x7x7) , 效果更好(更深 , 非线性更多) 。 有的同学会想到 , 虽然深层小 kernel 的堆叠容易产生优化问题 , 但这个问题已经被 ResNet 解决了(ResNet-152 有 50 层 3x3 卷积) , 那么这种做法还有什么缺陷呢?——ResNet 解决这个问题的代价是 , 模型即便理论上的最大感受野很大 , 实质上的有效深度其实并不深(参考文献 2) , 所以有效感受野并不大 。 这也可能是传统 CNN 虽然在 ImageNet 上跟 Transformer 差不多 , 但在下游任务上普遍不如 Transformer 的原因 。 也就是说 , ResNet 实质上帮助我们回避了「深层模型难以优化」的问题 , 而并没有真正解决它 。 既然深而 kernel 小的模型有这样的本质问题 , 浅而 kernel 大的设计范式效果会如何呢?

3. 理解 Transformer 之所以 work 的原因 。 已知 Transformer 性能拔群 , 特别是在检测、分割等下游任务上 。 Transformer 的基本组件是 self-attention , 而 self-attention 的实质是在全局尺度或较大的窗口内进行 Query-Key-Value 运算 。 那么 Transformer 性能强悍的原因是什么 , 是 Query-Key-Value的设计形式吗?我们猜测 , 会不会「全局尺度或较大的窗口」才是关键?对应到 CNN 中 , 这就需要用超大卷积核来验证 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。