Google自研芯片启示录:不为跑分只为打磨体验( 二 )

<拿起手机 - 拍照 - 成像>速度的真正因素 。

文章图片

图5/10

使用两颗降低频率的 X1 大核 , 去计算以往需要两颗 A76 中核来完成的工作 , 进而更加高效的完成以往需要更多时间来完成的计算 。 这种‘田忌赛马’一样的技巧 , 之所以之前并没有其他手机厂商可以效仿 , 原因正是因为处于产业链下游的手机品牌 , 其实在成本限制下 , 很难去依照自家系统/功能的性能需求对包括手机 SoC 在内的硬件量身定制 。

即便 Google Pixel 系列一直是手机计算摄影领域的领头羊 , 但从 2017 年发布的 Pixel 2 开始 , 连续四代 Pixel 手机都采用了同一颗 1200 万像素的传感器作为主摄配置;原因并非 Google 不舍得换新传感器芯片 , 而是基于新硬件重新训练算法成本太高 , 最终实现效果甚至不及现有的传感器 。

自那之后 , Google 每年在介绍 Pixel 新机在影像功能上的重点时 , 重点都只有一个 —— 计算摄影:从 Pixel 2/3 依靠单摄实现的‘人像模糊’、Pixel 4 时代的‘天文摄影模式’ , 到 Pixel 5 能给人像照片后期手动补光的‘人像光’ , 每一次 Pixel 相机加入新功能 , 都是 Google 在计算摄影领域的一次新突破 。

文章图片

图6/10

但仅凭计算摄影的算法进化 , 开发团队还是很快碰到了几乎难以逾越的硬件天花板:虽然 Google 能通过计算摄影算法让四代 Pixel 在同样主摄传感器下每年都能有新提升 , 但同样的‘魔法’却不能直接套用在视频拍摄部分上:因为手机端较弱的算力 , 无法支持借助机器学习实现的曝光堆叠算法在视频拍摄下同样使用 。 这也是过往使用高通 SoC 的 Pixel 手机视频拍摄质量并不算太优秀的原因 。

而到 Google Tensor 的硬件上 , Pixel 团队终于可以在针对性的定制硬件上来运行更多计算摄影所能实现的效果:作为本次新视频录制算法 —— HDRNet 的一部分 , Google 通过在 Tensor 中整合的计算单元 , 不仅实现了在 4K60FPS 视频录制时应用 HDR 效果 , 还解决了视频拍摄过程发热严重的问题:以往只能拍摄 4-5 分钟 , 到 Pixel 6 系列上则可以至少拍摄 20 分钟 。

文章图片

图7/10

终极解决方案

其实在 Google Tensor 之前 , Google 在给智能手机设计芯片这件事上 , 也走过类似当前小米/vivo 的阶段:如今负责研发 Tensor 的团队 , 其实早已在之前的 Pixel 手机中以加入协处理器的方式 , 来针对性提升手机某一部分的效能 。

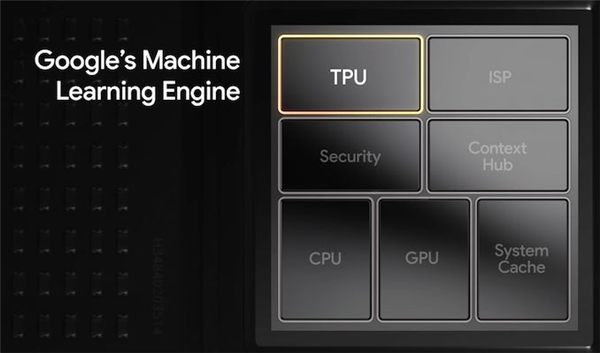

比如 Pixel 2/3 时代用于提升计算摄影/HDR+ 算法处理速度的 Pixel Visual Core、Pixel 4 上的迭代版 Pixel Neural Core , 以及贯穿始终的 Titan M 系列安全芯片 , 都是 Google 在涉足 SoC 芯片之前的尝试 , 到 Google Tensor 最终得以在 Pixel 6 系列上实际应用 , 这些原本都需要占用额外主板空间的协处理器 , 都能以一种更加高效的方式进一步整合进 SoC 之中 。

文章图片

图8/10

过去 , 在 Pixel 5 中加入‘环境光’功能之后 , Google 就已经在技术博客中吐槽‘让手机算力支持实现照片后期所需的算力 , 是一件很头疼的事’ , Google 不得不重新训练模型 , 让补光算法能在搭载高通骁龙 765G 的 Pixel 5 上正常使用 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。