文章图片

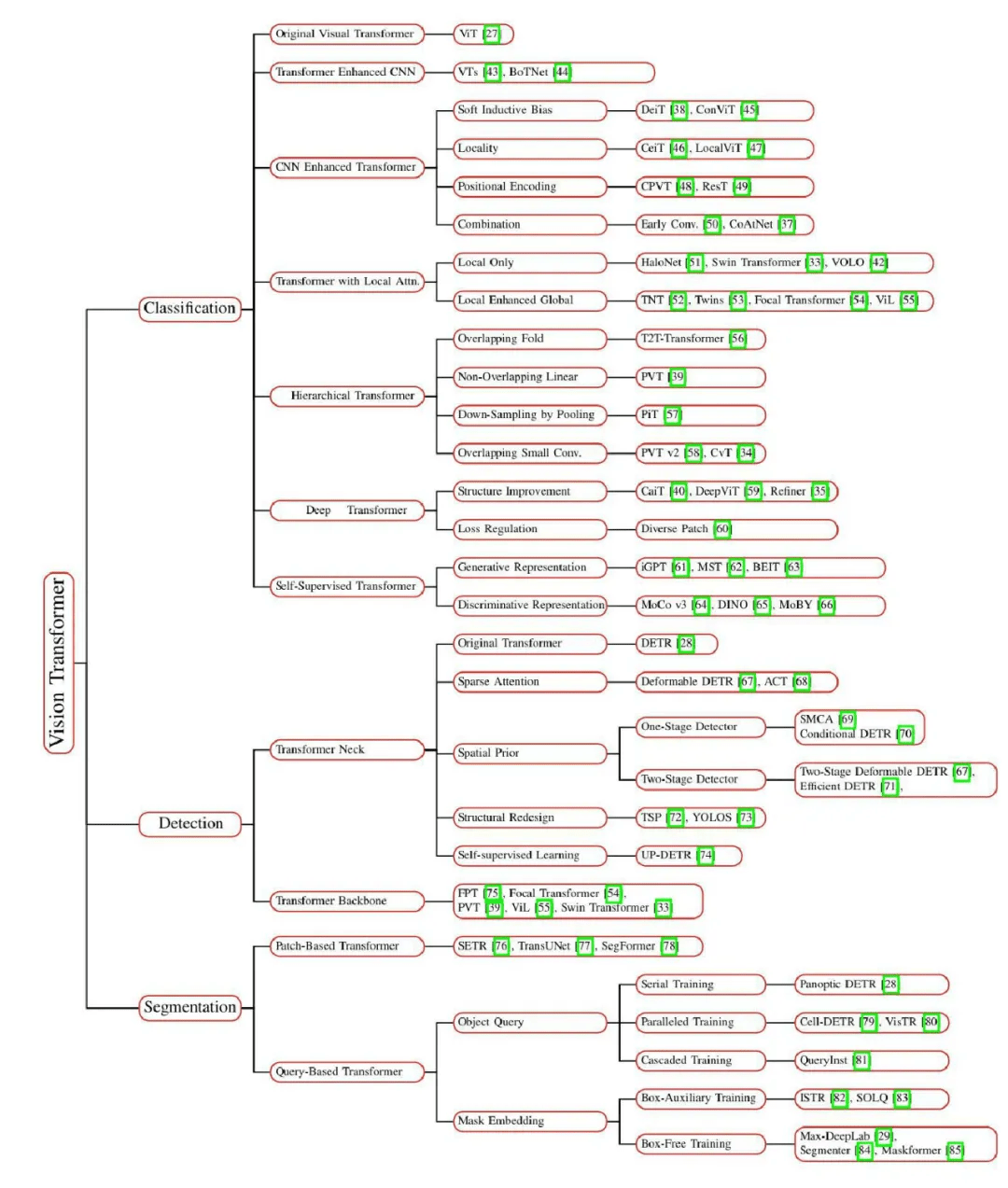

图 2 :视觉 Transformer 的分类

由于训练设置和定向任务各不相同 , 研究者也在不同配置上对这些 Transforme 进行了评估 , 以进行方便和直观的比较 。 此外 , 他们还揭示了一系列重要但仍需探索的特点 , 这些特点可能使 Transformer 从众多架构中脱颖而出 , 例如弥合视觉和序列 Transformer 之间差距的松弛高级语义嵌入 。 最后 , 他们提出了几个有前景的研究方向 。

用于分类的视觉 Transformer

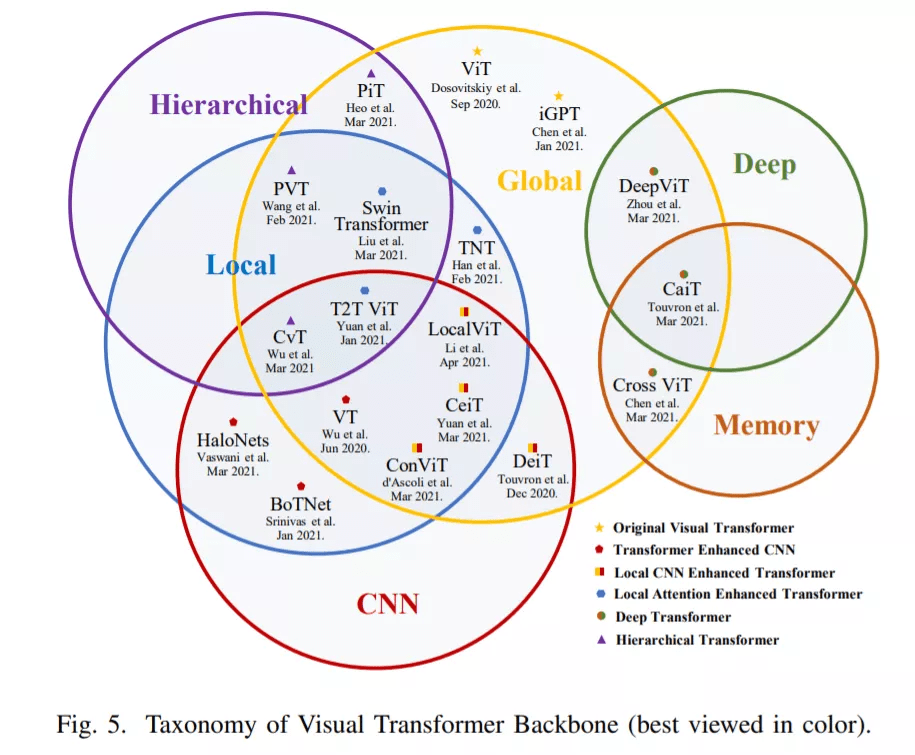

受 NLP 中 Transfomer 成功的启发 [2]–[5], [8] , 不少研究者尝试将 Transformer 引入图像分类任务 。 Vision Transformer(ViT)[27] 最先在主流分类基准上达到了可以媲美传统 CNN 的性能 。 在论文的第 III 章 , 研究者对 2021 年 6 月之前发布的 40 多个 Transformer 骨干进行了全面回顾 , 并根据动机和实现情况将其分成了六类 , 如下图 5 所示 。

文章图片

根据这一分类 , 研究者首先介绍了 ViT——用于图像分类的 Original Visual Transformer 。 接下来 , 他们讨论了 Transformer Enhanced CNN 方法 , 这些方法利用 Transformer 增强 CNN 骨干的长程依赖 。 Transformer 在全局建模方面能力突出 , 但在早期阶段会忽略局部信息 。 因此 , CNN Enhanced Transformer 方法利用适当的卷积归纳偏置来增强 Transformer , 而 Local Attention Enhanced Transformer 方法重新设计 patch 分区和注意力块 , 以增强 Transformer 的局部性并维持一个无卷积的架构 。

此外 , CNN 在性能和计算效率方面都受益于分层和深度结构[93] 。 受此启发 , 研究者们提出了 Hierarchical Transformer 和 Deep Transformer 方法 。 前者用一个金字塔 stem 代替分辨率固定的柱状结构 , 后者可以防止注意力图过于平滑 , 并在较深的层中增加其多样性 。 此外 , 他们还回顾了目前可用的自监督方法 。

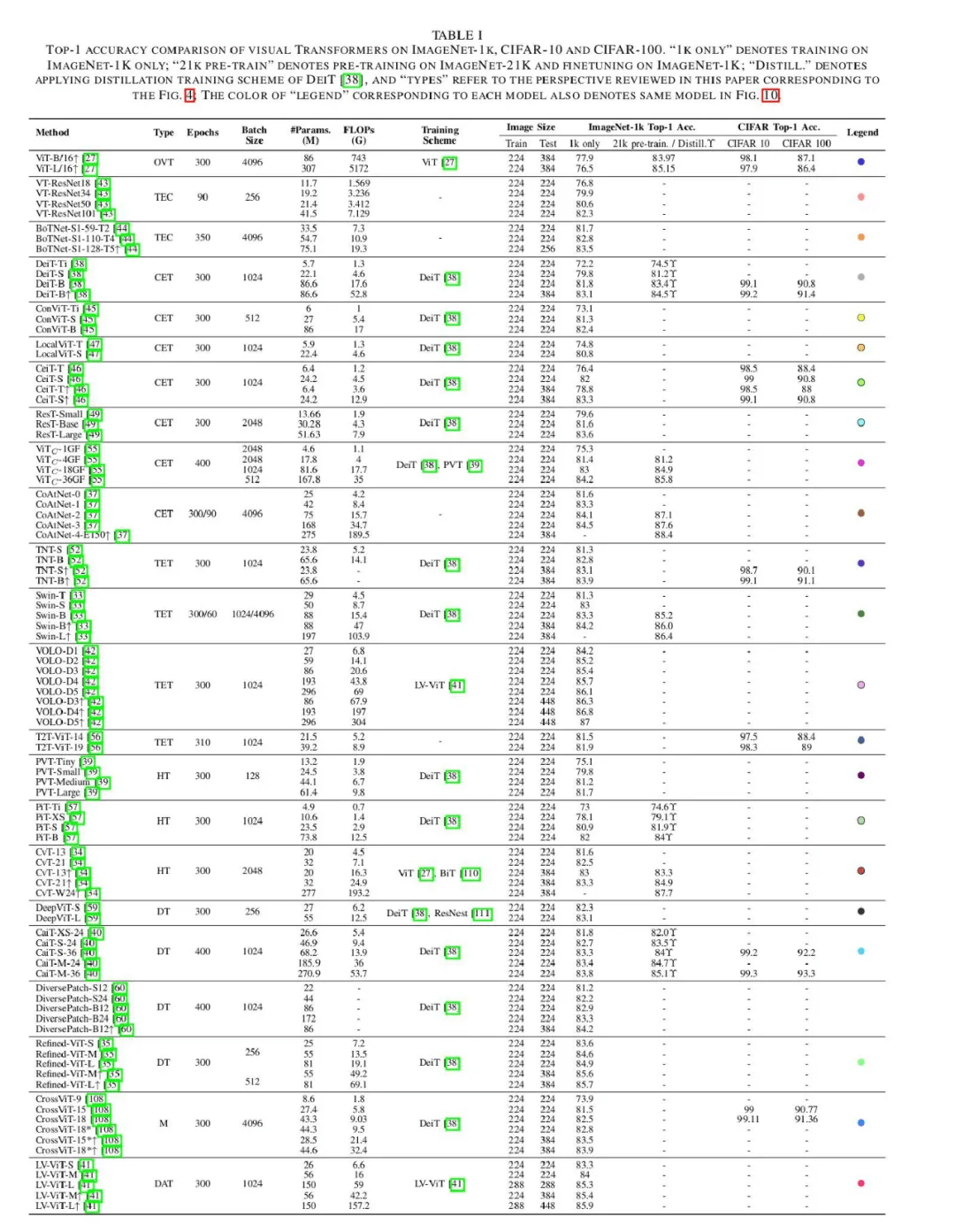

下表 I 总结了以上 Transformer 模型在主流分类基准上的表现:

文章图片

在梳理了这一部分的进展之后 , 研究者得出了以下结论:

对于分类任务 , 一个深度分层 Transformer 骨干可以有效降低计算复杂度 [39] , 还能避免深层中的特征过于平滑[35], [40], [59], [60] 。 同时 , 早期卷积 [37] 足以捕获低级特征 , 从而显著增强浅层的稳健性 , 降低计算复杂度 。 此外 , 卷积投影[46], [47] 和局部注意力机制 [33], [42] 都可以提高 Transformer 的局部性 。

用于检测的视觉 Transformer

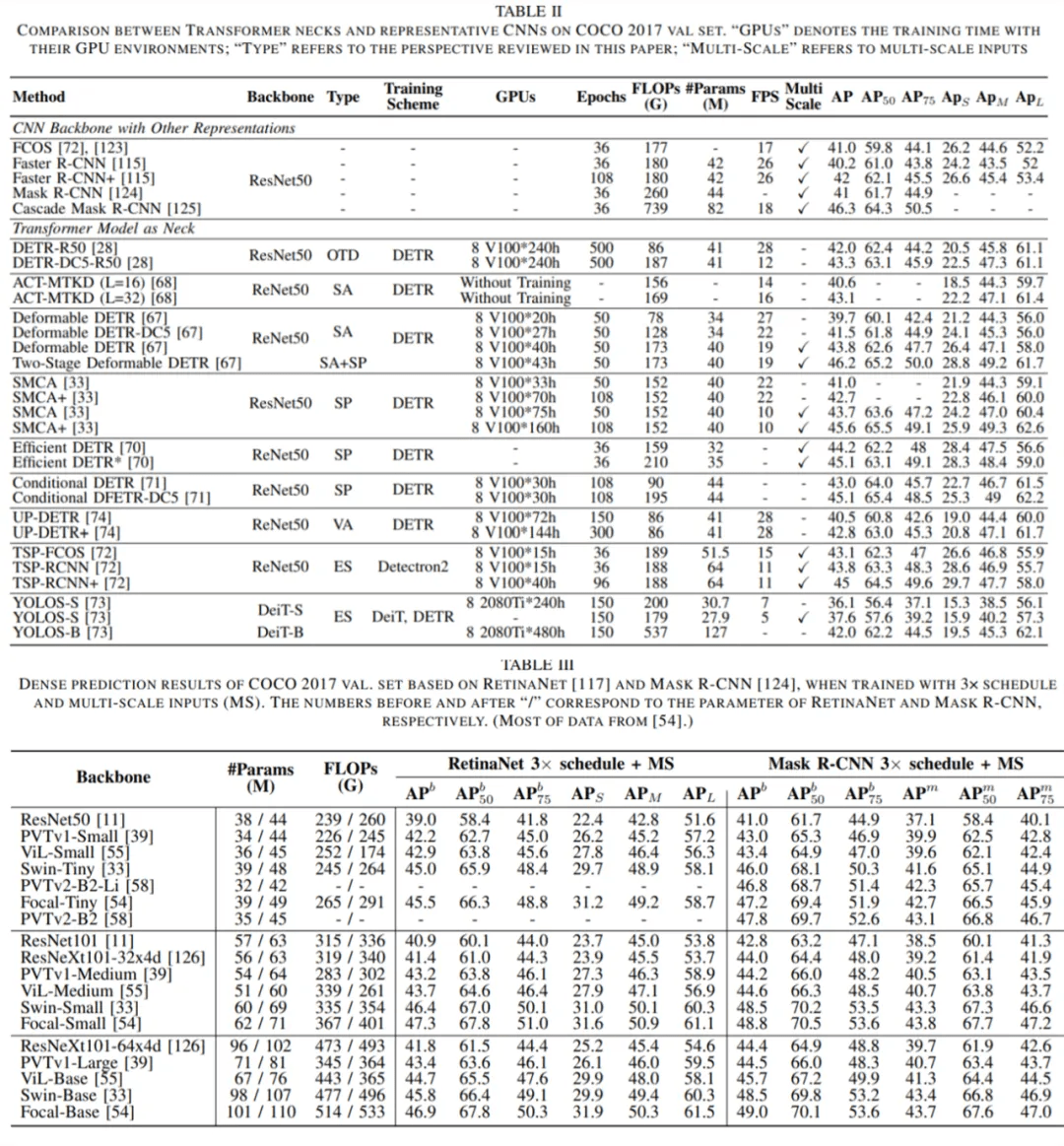

在第 IV 章中 , 研究者详细介绍了用于目标检测的视觉 Transformer 。 这些模型可以分为两类:作为颈部的 Transformer 和作为骨干的 Transformer 。 颈部检测器主要基于为 Transformer 结构指定的一个新表示 , 称为对象查询 , 即一组学习到的同等地聚合全局特征的参数 。 它们试图从加速收敛或提高性能的角度来解决最优融合范式 。 除了专门为检测任务设计的各种颈部外 , 一定比例的主干检测器也会考虑到特定的策略 。 最后 , 作者在表 II 和表 III 中比较了它们的性能 , 并分析了 Transformer 检测器的一些潜在改进 。

文章图片

在梳理了这一部分的进展之后 , 研究者得出了以下结论:

对于检测任务 , Transformer 颈部得益于编码器 - 解码器结构 , 比只使用编码器的 Transformer 检测器计算更少 。 因此 , 解码器是必要的 , 但是由于收敛缓慢 [72] , 它需要的 stack 极少[70] 。 此外 , 稀疏注意力[67] 有利于降低计算复杂度 , 加速 Transformer 的收敛 , 而空间先验 [67], [69], [71] 有利于提高 Transformer 的性能 , 稍微提高其收敛速度 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。