NVIDIA 让超级算力飞入“寻常百姓家”

随着Transformers模型的出现 , 现在的数据中心对算力的需求变得越来越大 , 要运行大的模型就需要更多的GPU , 数据并行和模型并行在未来工作训练中同时使用将成为一个趋势 。 如何既保持很高的算力 , 又保证业务的安全性 , 云原生技术对这样一个趋势是必不可少的 。

同时从Inference角度看 ,Inference依然需要很高的算力 。 因为随着现在模型越来越大 , 这时候需要跨服务器、跨Node做Inference 。 为了让Inference效率更高 , Inference走向分布式也慢慢出现了 , 这也需要更高算力和更高的通信能力 。

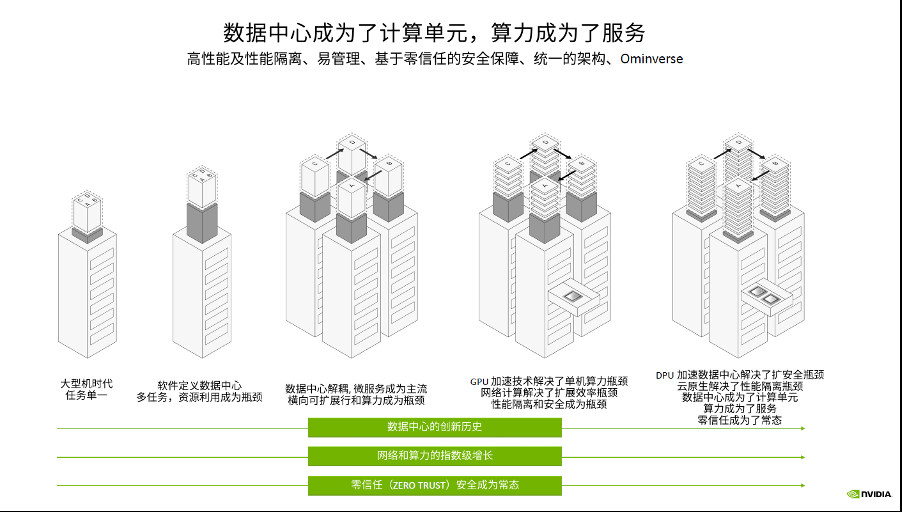

随着training和Inference技术的发展 , AI将成为数据中心里最主流的应用之一 , 现在数据中心逐渐成为了计算单元 , 算力成为了服务 。

超级计算中心要像一般的数据中心一样为大量的用户提供服务 , 就需要解决数据中心提供商所要解决的问题 , 如在零信任的环境下为租户提供服务、同时对大量的用户提供服务、确保每个租户之间的安全隔离等 。

文章图片

云原生超级计算(Cloud Native Supercomputing)技术的出现 , 为解决超算中心面临的挑战提供了解决方案 。 通过NVIDIA GPU可以解决超算中心的算力瓶颈 , 通过InfiniBand网络可以解决扩展效率的瓶颈 , 通过NVIDIA DPU可以解决性能隔离和数据安全的瓶颈 。

【如何让超级算力飞入“云数据中心”?】未来 , 数据中心中CPU、GPU、DPU , 3U一体缺一不可 , 这是数据中心成为计算单元的基础 , 也是算力成为服务的基础 , 真正让超级算力飞入云数据中心 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。