选自 Medium

作者:Adi Fuchs

机器之心编译

AI、机器学习、深度学习的概念可以追溯到几十年前 , 然而 , 它们在过去的十几年里才真正流行起来 , 这是为什么呢?AlexNet 的基本结构和之前的 CNN 架构也没有本质区别 , 为什么就能一鸣惊人?在这一系列文章中 , 前苹果、飞利浦、Mellanox(现属英伟达)工程师、普林斯顿大学博士 Adi Fuchs 尝试从 AI 加速器的角度为我们寻找这些问题的答案 。

文章图片

当代世界正在经历一场革命 , 人类的体验从未与科技如此紧密地结合在一起 。 过去 , 科技公司通过观察用户行为、研究市场趋势 , 在一个通常需要数月甚至数年时间的周期中优化产品线来改进产品 。 如今 , 人工智能已经为无需人工干预就能驱动人机反馈的自我改进(self-improving)算法铺平了道路:人类体验的提升给好的技术解决方案带去奖励 , 而这些技术解决方案反过来又会提供更好的人类体验 。 这一切都是在数百万(甚至数十亿)用户的规模下完成的 , 并极大地缩短了产品优化周期 。

人工智能的成功归功于三个重要的趋势:1)新颖的研究项目推动新的算法和适用的用例;2)拥有收集、组织和分析大量用户数据的集中式实体(例如云服务)的能力;3)新颖的计算基础设施 , 能够快速处理大规模数据 。

在这个系列的文章中 , 前苹果、飞利浦、Mellanox(现属英伟达)工程师、普林斯顿大学博士 Adi Fuchs 将重点关注第三个趋势 。 具体来说 , 他将对 AI 应用中的加速器做一个高层次的概述——AI 加速器是什么?它们是如何变得如此流行的?正如在后面的文章中所讨论的 , 加速器源自一个更广泛的概念 , 而不仅仅是一种特定类型的系统或实现 。 而且 , 它们也不是纯硬件驱动的 。 事实上 , AI 加速器行业的大部分焦点都集中在构建稳健而复杂的软件库和编译器工具链上 。

以下是第一部分的内容 , 其余部分将在后续的文章中更新 。

人工智能不仅仅是软件和算法

AI / 机器学习 / 深度学习的概念可以追溯到 50 多年以前 , 然而 , 它们在过去的十几年里才真正流行起来 。 这是为什么呢?

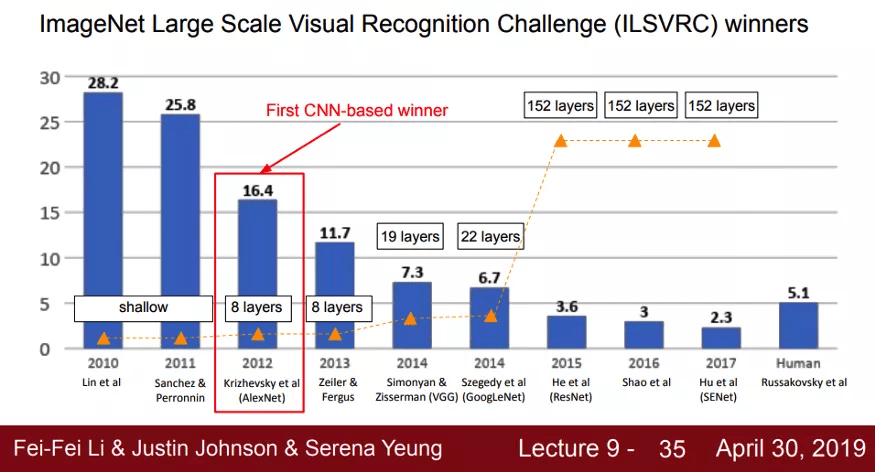

很多人认为 , 深度学习的复兴始于 2012 年 。 当时 , 来自多伦多大学的 Alex Krizhevsky、Ilya Sutskever、Geoffrey Hinton 等人提出了一个名为「AlexNet」的深度神经网络并凭借该网络赢得了 2012 年大规模视觉识别挑战赛的冠军 。 在这场比赛中 , 参赛者需要完成一个名叫「object region」的任务 , 即给定一张包含某目标的图像和一串目标类别(如飞机、瓶子、猫) , 每个团队的实现都需要识别出图像中的目标属于哪个类 。

AlexNet 的表现颇具颠覆性 。 这是获胜团队首次使用一种名为「卷积神经网络(CNN)」的深度学习架构 。 由于表现过于惊艳 , 之后几年的 ImageNet 挑战赛冠军都沿用了 CNN 。 这是计算机视觉史上的一个关键时刻 , 也激发了人们将深度学习应用于其他领域(如 NLP、机器人、推荐系统)的兴趣 。

文章图片

ImageNet 挑战赛冠军团队的分类错误率逐年变化情况(越低越好) 。

有意思的是 , AlexNet 的基本结构和之前那些 CNN 架构并没有太大区别 , 比如 Yann LeCun 等人 1998 年提出的 LeNet-5 。 当然 , 这么说并不是想抹杀 AlexNet 的创新性 , 但这确实引出了一个问题:「既然 CNN 不是什么新东西 , AlexNet 的巨大成功还可以归因于哪些要素呢?」从摘要可以看出 , 作者确实使用了一些新颖的算法技术:

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。