释放CPU算力:DPU可以执行原本需要CPU处理的网络、存储和安全等任务 , 释放CPU的运算能力可以被释放出来 , 去执行其他企业应用 。

释放服务器容量:DPU还释放了服务器的容量 , 以便它们可以恢复到应用程序计算 。 在一些具有大量I / O和沉重虚拟化的系统上内核成本缩减一半 , 因此吞吐量提高了2倍 。 除了内核的成本 , 还要计算整个机器的成本 , 包括其内存和I / O以及所释放的工作量 , 采用DPU之后 , 几乎可以用一半的成本来保证原有的安全性和灵活性 。

DPU的核心应用在于分布式存储、网络计算和网络安全领域的成本削减和性能提升 。

DPU作为一个可编程处理器 , 运行的都是非应用型负载 , 从而可以让服务器CPU资源更好地服务应用负载 , 对数据中心来说 , 是通过更明细的分工 , 实现效率的提升 , 总体系统成本的削减 。

04

DPU同时将助力隐私计算和边缘端计算的发展

隐私计算:基于隐私保护技术的数据要素化 , 使得数据所有权和使用权分离 , 使得数据价值可以流动 , 对算力和网络都有巨大的要求 。

算力:

- 多方安全计算、联邦学习、同态加密、差分隐私、零知识证明等密码学方法 , 性能低 , 需要的计算资源比明文多几个数量级;

- DPU可以带来改善 。 DPU的本质是将计算向存储靠近 。 类似的方案有存内计算、近内存计算等框架 , 还有将计算和数据融合的雾计算 。 以数据为中心的处理器首先解决的是性能问题 。

- 算力不足可以用硬件加速缓解 , 但是网络带宽 , 尤其是公网环境 , 有限的带宽是目前落地的瓶颈 。 尤其是多方安全计算MPC、联邦学习等需要多轮网络交互的技术 。

- 对于性能问题 , 在数据的流动 , 即网络传输 , 是数据中心的第二大职能 。 诸如网络协议处理、传输压缩、数据加密等任务都是网卡设备的职能 。 DPU可以被集成到SmartNIC(下一代网卡)中 , 从而带来网卡的性能提升 , 那么它不仅可以处理物理层和链路层的数据帧 , 也有能力承担网络层和应用层的职能 。

NVIDIA DRIVE Atlan是新一代AI自动驾驶汽车处理器 , 算力将达到1000TOPS , 约是上一代Orin处理器的4倍 , 超过了大多数L5无人驾驶出租车的总计算能力 , 堪称 “车轮上的数据中心” , 将车辆的整个计算基础设施集中到一块系统级芯片上 。

这是DRIVE平台首次集成DPU , 通过Arm核为自动驾驶汽车带来数据中心级的网络 , 致力于应用到2025年的车型 。

该SoC采用下一代GPU的体系结构、新型Arm CPU内核、新深度学习和计算机视觉加速器 , 并内置为先进的网络、存储和安全服务的BlueField DPU , 网络速度可达400Gbps 。

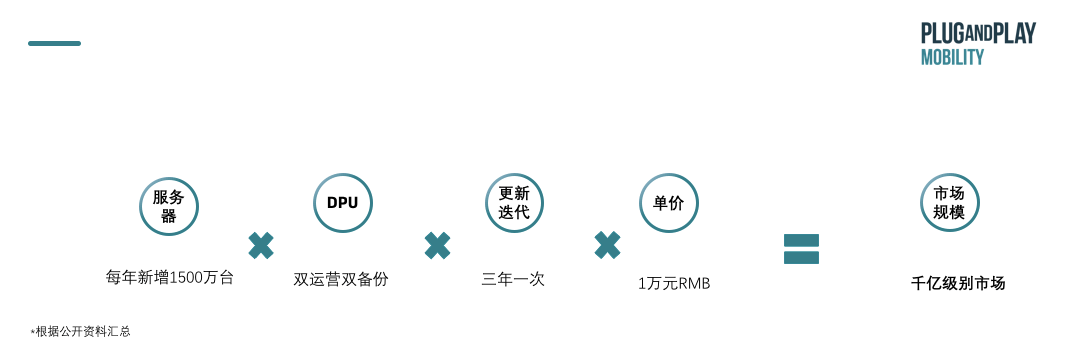

据Fungible和英伟达的预测 , 用于数据中心的DPU量级将达到和数据中心服务器等量的级别 。 数据中心里的服务器 , 一般都需要两张智能网卡 , 双运营双备份以保证安全 , 且一般需要三年更新迭代一次 , 服务器每年新增大约千万量级 , 每台服务器可能没有GPU , 但一定会有一颗或者多颗DPU , 好比每台服务器都必须配网卡一样 。 服务器每年新增大约1500万台 , 每颗DPU如果以1万元计算 , 这将是千亿量级的市场规模 。

按照目前数据中心市场判断 , 整体市场规模在千亿级别

文章图片

05 DPU 由智能网卡发展而来 , 未来最终将成为基础设施处理的重要工具 以太网控制器开始 , 提高计算能力 , 从而使普通的NIC变得智能:

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。