此外 , 他们证明了 SGD 由于压缩阶段而达到了这个最优界限 , 并在表示压缩上导出了一个新的高斯界限 , 同时将其与压缩时间联系起来 。 他们的结果还表明 , 网络的层收敛到 IB 理论界限 , 导致编码器和解码器分布之间的自洽关系 。

文章图片

第四章讨论了将 IB 应用于深度神经网络时最困难的问题之一 —— 估计高维空间中的互信息 。

尽管互信息在数据科学中是一个重要的量 , 但它在计算方面一直很有挑战性 。 互信息的计算只适用于离散变量或已知概率分布的有限数量的问题 。 为了更好地估计信息论数量(information-theoretic quantities)并研究泛化信号 , 作者研究了几个框架 , 并利用了最近的理论研究成果 , 如神经正切核(NTK)框架 。

在研究中 , 他们发现 , 对于无限宽的神经网络的无限集合 , 他们可以获得许多信息论数量及其边界的易处理的计算 。 许多量可以通过网络的核(kernel)以封闭形式的解来描述 。 通过分析这些内容 , 我们可以了解网络的重要信息论数量 , 以及压缩、泛化和样本大小之间的关系 。

文章图片

第五章介绍了一个新的信息论框架 —— 双重信息瓶颈(dualIB) 。

尽管 IB 框架有很多优点 , 但它也有几个缺点:IB 是完全非参数化的 , 并且只在概率空间上运行 。 此外 , IB 公式不涉及预测未见模式的任务 , 并假定能够完全获取联合概率 。 因此 , 作者开发了 dualIB , 它仅通过在失真函数中的项之间进行切换来解决 IB 的一些缺点 。 dualIB 可以解释数据的已知特征 , 并使用它们对未知的例子做出更好的预测 。 作者提供了 dualIB 自洽方程 , 该方程允许他们获得解析解 。 局部稳定性分析揭示了解的临界点的潜在结构 , 产生了最佳模式表示的完整分叉图 。

他们发现了 dualIB 目标的几个有趣的性质 。 首先 , 当以参数化形式表达时 , dualIB 保留其结构 。 它还优化了平均预测误差指数 , 从而提高了关于样本大小的预测精度 。 除了 dualIB 的解析解 , 他们还提供了一个变分 dualIB 框架 , 该框架使用深度神经网络来优化泛函 。 该框架实现了真实世界数据集的 dualIB 的实现 。 通过它 , 作者对其动态变化进行了实验评估 , 并验证了现代深度神经网络的理论预测 。

文章图片

文章图片

总之 , 该论文提出了一个新的信息论视角来研究深度神经网络 , 它利用了深度学习和 IB 框架之间的对应关系 。 这一独特的视角可以提供许多好处 , 比如对深度神经网络有更深入的理解 , 解释它们的行为 , 并改善它们的性能 。 同时 , 他们的研究也开拓了新的理论和实践研究问题 。

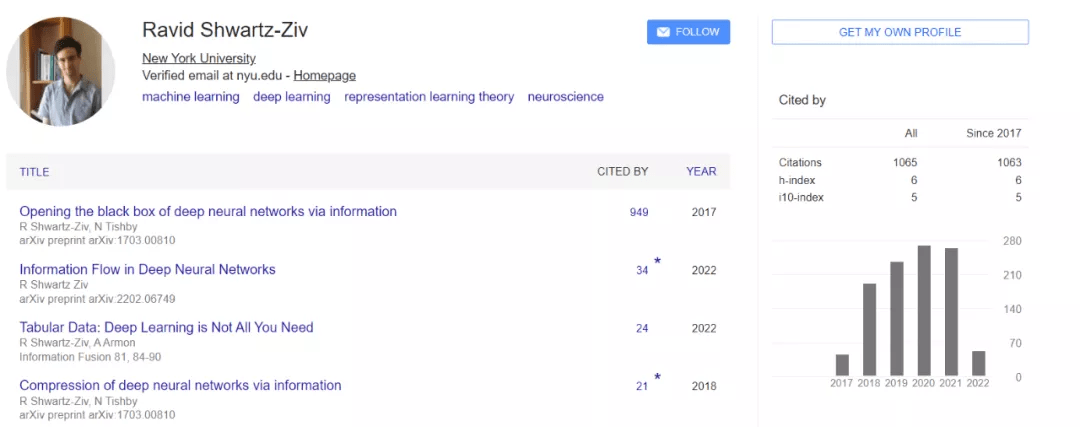

Ravid Shwartz-Ziv 简介

Ravid Shwartz-Ziv 是希伯来大学计算机科学与神经科学博士 , 读博期间专注于深度神经网络与信息论之间的联系 , 试图基于信息论对 DNN 进行更深入的理解 , 并将其应用于大规模的问题 。 2018 年 , 他拿到了谷歌博士生奖研金 。

2021 年 , Shwartz-Ziv 博士毕业并进入纽约大学数据科学中心担任 CDS Faculty Fellow , 与 Andrew Gordon Wilson、Yann Lecun 等人一起研究贝叶斯深度网络、信息论和自监督学习 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。