机器之心报道

编辑:张倩

这篇博士论文在 Tishby 的指导下完成 , 汇集了师徒二人及其他合著者在深度学习 + 信息论领域的研究成果 , 非常值得一读 。深度学习的黑箱属性一直为人所诟病 , 很多研究者都在努力解决这一问题 。 其中 , 用信息论来提高深度神经网络的可解释性是一个非常有趣的方向 。

在这个方向上 , 「信息瓶颈」提出者、希伯来大学计算机科学教授 Naftali Tishby 及其学生的论文属于必读文献 。

2015 年 , Tishby 和他的学生 Noga Zaslavsky 发表了一篇论文 , 假设深度学习是一个信息瓶颈程序 , 尽可能地压缩数据噪声 , 保留数据想表达的信息 。 也就是说 , 神经网络就像把信息挤进瓶颈一样 , 只留下与一般概念最为相关的特征 , 去掉大量无关的噪音数据 。

2017 年 , Tishby 和他的另一个学生 Ravid Shwartz-Ziv 联合进行了一场引入注目的实验 , 揭示了发生在深度学习之中的挤压过程 , 表明深度神经网络在压缩状态中提高泛化能力 , 从而更加擅长标记测试数据 。 这篇论文就是大名鼎鼎的《 Opening the black box of Deep Neural Networks via Information 》 。 深度学习先驱 Geoffrey Hinton 在听了 Tishby 的报告之后给他发了邮件:「信息瓶颈极其有趣 , 我要再听一万遍才能真正理解它 , 当今能听到如此原创的想法非常难得 , 或许它就是解开谜题的那把钥匙 。 」纽约大学心理学和数据科学助理教授 Brenden Lake 也认为 , Tishby 的研究成果是「打开神经网络黑箱的重要一步」 。

文章图片

在这篇论文之后 , Tishby 及其学生继续在深度学习 + 信息论的方向上深入研究 。 但不幸的是 , Tishby 于去年 8 月份离世 , 剩下的问题只能交给后人来探索 。

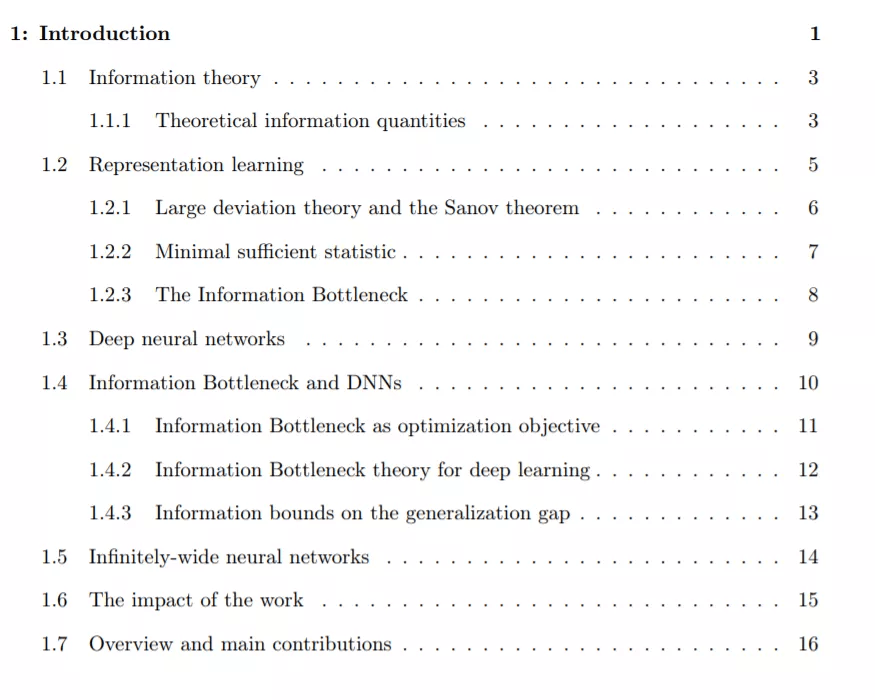

在 Tishby 去世的这年 , Ravid Shwartz-Ziv 完成了他的博士论文 ——《 Information Flow in Deep Neural Networks 》 。

这篇论文在 Tishby 的指导下完成 , 汇集了师徒二人及其他合著者在深度学习 + 信息论领域的研究成果 , 非常值得一读 。

文章图片

最近 , Ravid Shwartz-Ziv 表示 , 他已经将该论文上传到了 arXiv 。

文章图片

文章图片

论文链接:https://arxiv.org/pdf/2202.06749.pdf

以下是论文的大致内容 。

Ravid Shwartz-Ziv 的博士论文

尽管深度神经网络已经取得了巨大的成功 , 但我们还没有一个全面的理论来解释这些网络如何工作或如何构造 。 深度网络通常被视为黑盒 , 我们无法清楚地解释它们的预测结果或可靠性 。 如今 , 了解深度神经网络的突破性性能是科学界面临的最大挑战之一 。 为了更有效地使用这些算法并改进它们 , 我们需要了解它们的动态行为(dynamic behavior)以及它们学习新表示的能力 。

在这篇博士论文中 , 作者应用了信息论中的原理和技术来解决上述问题 , 以提高我们的理论理解 , 并运用这一理解来设计更好的算法 。

文章图片

论文的主要成果和贡献可以分为三个部分 , 具体如下:

第二章和第三章介绍了作者针对深度学习模型提出的信息论方法 。

作为对深度学习系统的解释 , 作者提出使用信息瓶颈(IB)理论 。 这种分析网络的新范式揭示了它们的分层结构、泛化能力和学习动态 。 基于这一分析 , 作者发现深度网络优化了每一层关于输入和输出变量的互信息 , 导致每一层都要在压缩和预测之间做出权衡 。 作者对这些网络的分析和数值研究表明 , 随机梯度下降算法遵循 IB 权衡原则 , 分两个阶段工作:快速经验误差最小化阶段和慢速表示压缩阶段 。 这些阶段通过每层不同的信噪比(SNR)来区分 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。