机器之心报道

编辑:张倩

没有了神经网络 , 辐射场(Radiance Fields)也能达到和神经辐射场(Neural Radiance Fields , NeRFs)相同的效果 , 但收敛速度快了 100 多倍 。2020 年 , 加州大学伯克利分校、谷歌、加州大学圣地亚哥分校的研究者提出了一种名为「NeRF」的 2D 图像转 3D 模型 , 可以利用少数几张静态图像生成多视角的逼真 3D 图像 。 其改进版模型 NeRF-W (NeRF in the Wild)还可以适应充满光线变化以及遮挡的户外环境 , 分分钟生成 3D 旅游观光大片 。

文章图片

NeRF 模型 demo 。

文章图片

NeRF-W 模型 demo 。

然而 , 这些惊艳的效果是非常消耗算力的:每帧图要渲染 30 秒 , 模型用单个 GPU 要训练一天 。 因此 , 后续的多篇论文都在算力成本方面进行了改进 , 尤其是渲染方面 。 但是 , 模型的训练成本并没有显著降低 , 使用单个 GPU 训练仍然需要花费数小时 , 这成为限制其落地的一大瓶颈 。

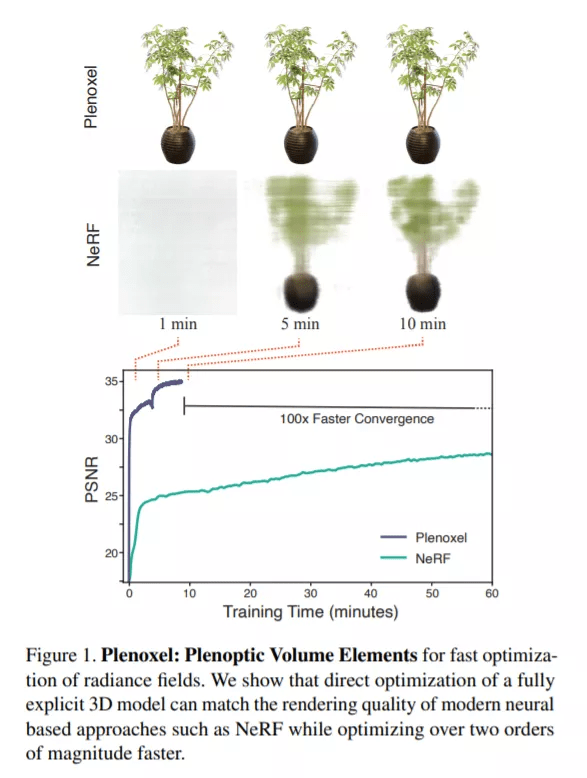

在一篇新论文中 , 来自加州大学伯克利分校的研究者瞄准了这一问题 , 提出了一种名为 Plenoxels 的新方法 。 这项新研究表明 , 即使没有神经网络 , 从头训练一个辐射场(radiance field)也能达到 NeRF 的生成质量 , 而且优化速度提升了两个数量级 。

文章图片

- 论文链接:https://arxiv.org/pdf/2112.05131.pdf

- 项目主页:https://alexyu.net/plenoxels/

- 代码链接:https://github.com/sxyu/svox2

【神经辐射场去掉「神经」,训练速度提升100多倍,3D效果质量不减】

文章图片

文章图片

具体来说 , 研究者提出了一个显式的体素表示方法 , 该方法基于一个不含任何神经网络的 view-dependent 稀疏体素网格 。 新模型可以渲染逼真的新视点 , 并利用训练视图上的可微渲染损失和 variation regularizer 对校准的 2D 照片进行端到端优化 。

他们把该模型称为 Plenoxel(plenoptic volume elements) , 因为它由稀疏体素网格组成 , 每个体素网格存储不透明度和球谐系数信息 。 这些系数被 interpolated , 以在空间中连续建模完整的全光函数 。 为了在单个 GPU 上实现高分辨率 , 研究者修剪了空体素 , 并遵循从粗到细的优化策略 。 虽然核心模型是一个有界体素网格 , 但他们可以通过两种方法来建模无界场景:1)使用标准化设备坐标(用于 forward-facing 场景);用多球体图像围绕网格来编码背景(用于 360° 场景) 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。