20 个 GPU 可承载相当于全球互联网流量、Grace CPU 超级芯片现世,英伟达这届 GTC 发布了什么?

整理 | 苏宓

出品 | CSDN(ID:CSDNnews)

技术的极限在哪里?

想必科技圈给出回答大概率是没有!

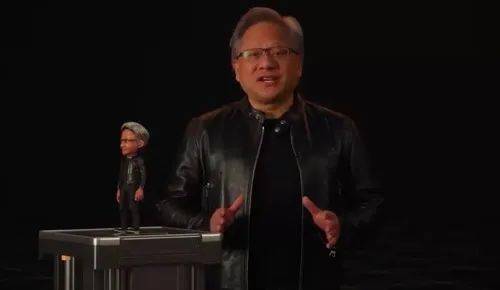

这不 , 在 GTC 2022 Keynote 上 , 身着黑色夹克「战袍」的黄仁勋挂帅 , 英伟达带着采用台积电 4nm 工艺建造、拥有 800 亿个晶体管的 H100 GPU , 基于最新 Arm v9 架构的 Grace CPU , 以及具有元宇宙属性的 Omniverse 和自动驾驶平台 Hyperion 9 等软硬件再次刷新了自己乃至全行业的记录 。

文章图片

20 个 H100 GPU 可维持相当于整个世界的互联网流量?

英伟达 , 一家你可以称之为“芯片霸主” , 也可以叫做是一家人工智能计算以及元宇宙大玩家的公司 。

在其最擅长的 GPU 领域中 , 英伟达宣布 Hopper? 架构的下一代加速计算平台到来 , 它的性能比上一代产品跃升了一个数量级 , 大力推动了下一波人工智能数据中心的发展 。

这款新架构以美国计算机科学家先驱 Grace Hopper 的名字命名 , 替代两年前推出的 NVIDIA Ampere 架构 。

除此之外 , 英伟达还发布了其首款基于 Hopper 的 GPU——英伟达 H100 。

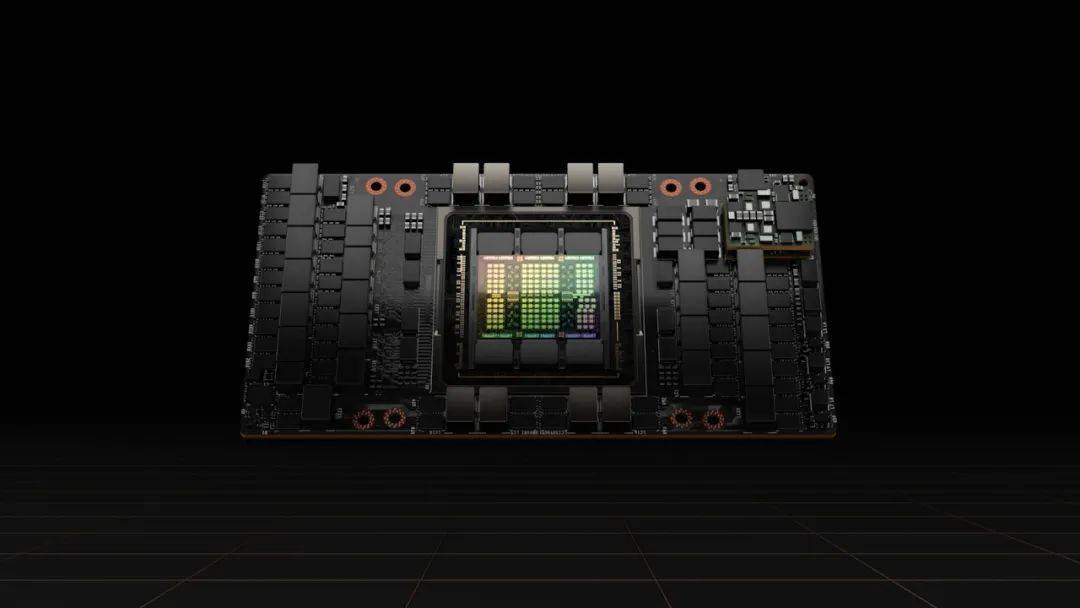

文章图片

作为 A100 的替代者 , 在设计方面 , 与之前网传 5nm 工艺制造有所偏差 , 这款 H100 采用了当前最先进的台积电 4nm 工艺、拥有 800 亿个晶体管 , 可以加快 AI、HPC、内存带宽、互连和通信的发展 , 甚至能够实现每秒近 5 兆字节的外部连接 。

在性能方面 , H100 采用了自然语言处理的标准模型 , 即新的 Transformer Engine 。 H100 加速器可以将这些网络的速度提高到上一代的 6 倍而不损失精度 。

此外 , H100 也是第一个支持 PCIe Gen5 的 GPU , 也是第一个利用 HBM3 的GPU , 实现了 3TB/s 的内存带宽 。 20 个 H100 GPU 可以维持相当于整个世界的互联网流量 , 使客户有可能提供先进的推荐系统和大型语言模型实时运行数据推理 。

除了以上 , H100 还在技术上实现了以下突破:

- 实现第二代安全多实例GPU 。 上一代产品中 , 英伟达的多实例 GPU 技术可将一个 GPU 划分为七个较小的、完全隔离的实例 , 以处理不同类型的工作 。 通过在云环境中为每个 GPU 实例提供安全的多租户配置 , Hopper 架构将 MIG 功能比上一代扩展了 7 倍 。

- 保密计算 。 H100 是世界上第一个具有保密计算能力的加速器 , 可以在处理 AI 模型和客户数据时保护它们 。 客户还可以将保密计算应用于医疗保健和金融服务等隐私敏感行业的联邦学习 , 以及共享云基础设施上 。

- 支持第四代 NVLink 技术 。 为了加速最大的人工智能模型 , 英伟达将 NVLink 与新的外部 NVLink Switch 相结合 , 将 NVLink 作为扩展网络扩展到服务器之外 , 与使用 NVIDIA HDR Quantum InfiniBand 的上一代相比 , 最多可以连接多达 256 个 H100 GPU , 带宽也高出了 9 倍 。

- 新的 DPX 指令对动态编程进行了加速 , 该指令被广泛用于各种算法 , 包括路线优化和基因组学 。 与 CPU 相比 , 动态编程的速度提高了 40 倍 , 与上一代 GPU 相比提高了 7 倍 。 这包括 Floyd-Warshall 算法 , 为动态仓库环境中的自主机器人车队寻找最佳路线 , 以及 Smith-Waterman 算法 , 用于 DNA 和蛋白质分类和折叠的序列对齐 。

值得注意的是 , 英伟达还基于 H100 发布了系列产品 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。