Master版的阿尔法狗,怎么说都应该算是人类的学生,只不过青出于蓝而胜于蓝,现在被“纯自学野路子版”的阿尔法元吊打,的确颇有点让人情何以堪的滋味 。

【AlphaGo Zero 阿尔法元为什么能无师自通?】

文章插图

要解释为什么阿尔法元(AlphaGo Zero)能无师自通,那答案取决于两个因素:首先是围棋的本质,其次是算法 。即围棋这类完全信息博弈并且胜负判断精确且规则明确的问题,在本质上可以不依赖前人的探索,而完全从零开始在足够巧妙的算法和硬件配合下,既能在短时间内到达相当的水平和高度 。这依赖的是首先可以进行自对弈,其次能从自对弈中提取分析胜败的相关因素和特征,并投入到下一轮自对弈中去进行检验 。

对比一下人类的自学能力所需要的前置条件:首先,得有一个合格的人脑,即一个大约由数百亿神经元组合连接而成的硬件系统,其次得有一个基本的初始输入,包括认字脱盲拥有基础阅读理解能力,这可以类比为人类的算法系统 。在这两者配合之下,至少部分人就拥有了不依赖老师,而自己学习新知识甚至开拓新领域的能力 。

而AlphaGoZero并非一无所有,它有两大神经网络架构,供它从每一局的自对弈中提取分析胜败的特征算法,即自我反省能力,自我总结能力,并且将这种反省和总结立即投入到下一局的实战中进行校验的能力 。

而之所以能只通过490万局自对弈就能胜过从前三千万局的成果,我想这主要是因为算法的改进,尤其是特征提取方面的改进造成的,要知道从前的AlpahGo的一些基础特征,比如虎口之类的认知靠的是外界输入设定的,这说明老版本的特征提取能力不强,当然在能够利用人类经验的情况下,许多棋型特征都可以作为先验知识输入,这样在初期显示出来的水平较高,但在后期则可能受制于这些权重较高的经验而误入歧途 。

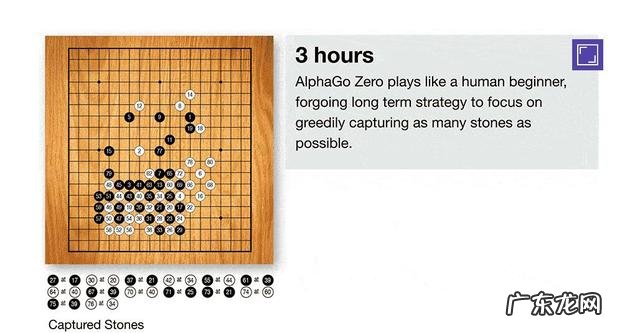

这就是为何阿尔法元的成功,证明了两件事 。其一,围棋是可以完全从零开始进行AI化的游戏,其二,人类经验在一定程度上是有局限的,会限制AI在极高水平时候的提高和成长 。但我们还是得看到,阿尔法元 vs Master版本时候,并未到达全胜,总还是给人类经验留下点颜面了 。另外,看到阿尔法元的成长史,也颇为有趣,万丈高楼也得有个地基啊 。

- 追寻Rookie?V5官宣Zero和Nofe教练强势加入

- dietcoke和zerocoke有什么区别?

- 最新的奥密克戎变异株最接近阿尔法,近3万个碱基中有30多个变异

- Resolution Games 已收购 Zero Inde

- 自诩成长中的好帮手,阿尔法蛋实用性引争议

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。