文章插图

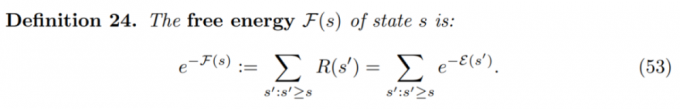

如何估计自由能呢?让我们考虑条件式 GFlowNet 的一种特殊情况, 它允许网络估计自由能 F(s) 。 为此, 研究者提议训练一个条件式 GFlowNet, 其中条件输入 x 是轨迹中较早的状态 s 。

状态条件式 GFlowNet 的定义如下, 并且将 F(s|s)定义为 conditional state self-flow 。

文章插图

研究者表示, 使用 GFlowNet 可以训练基于能量的模型 。 具体地, GFlowNet 被训练用于将能量函数转换为逼近对应的采样器 。 因此, GFlowNet 可以用作 MCMC 采样的替代方法 。

此外, GFlowNet 还可用于主动学习 。 Bengio et al. (2021)使用的主动学习方案中, GFlowNet 被用于对候选 x 进行采样, 其中研究者预计奖励 R(x)通常很大, 这是因为 GFlowNet 与 R(x)成比例地采样 。

多流、分布式 GFlowNets、无监督 GFlowNets 和帕累托 GFlowNets

与分布式强化学习类似, 非常有趣的一点是, 泛化 GFlowNets 不仅可以捕获可实现的最终奖励的预期值, 还能得到其他分布式统计数据 。 更一般地讲, GFlowNets 可以被想象成一个族(family), 其中每一个都可以在自身流中对感兴趣的特定的未来环境结果进行建模 。

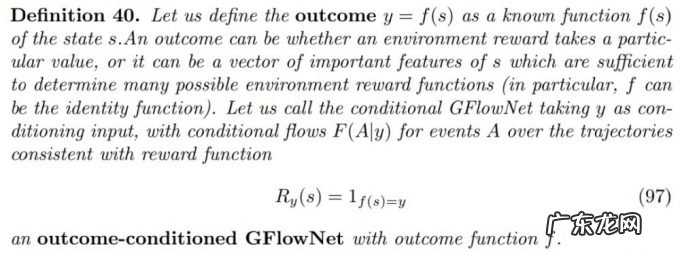

下图为以结果为条件的(outcome-conditioned)GFlowNet 的定义:

文章插图

在实践中, GFlowNet 永远无法完美地训练完成, 因此应当将这种以结果为条件的 GFlowNet 与强化学习中以目标为条件的策略或者奖励条件颠倒的强化学习(upside-down RL)同等看待 。 未来更是可以将这些以结果为条件的 GFlowNets 扩展到随机奖励或随机环境中 。

此外, 训练一个以结果为条件的 GFlowNet 只能离线完成, 因为条件输入(如最终返回)可能只有在轨迹被采样后才能知道 。

文章插图

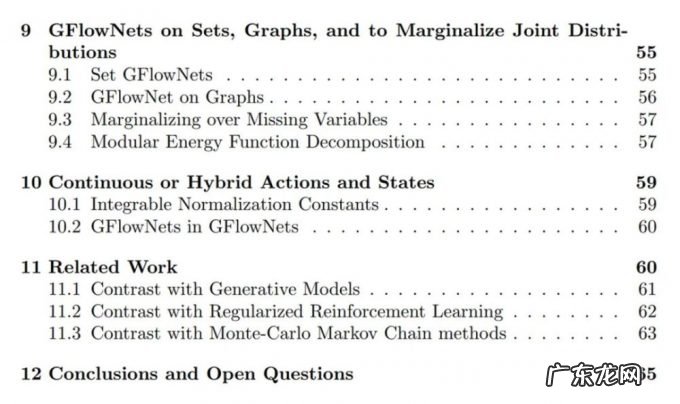

论文的完整目录如下:

文章插图

文章插图

2021 NeurIPS MeetUp China

受疫情影响, NeurIPS 2021依然选择了线上的形式举办 。 虽然这可以为大家节省一笔注册、机票、住宿开支, 但不能线下参与这场一年一度的学术会议、与学术大咖近距离交流讨论还是有些遗憾 。

我们将在NeurIPS官方支持下, 于12月11日在上海博雅酒店举办线下NeurIPS MeetUp China, 促进国内人工智能学术交流 。

2021 NeurIPS MeetUp China将设置 Keynote、圆桌论坛、论文分享、 Poster和企业招聘等环节, 邀请顶级专家、论文作者与现场参会观众共同交流 。

- 小学生优秀作文期刊 小学生优秀作文

- 引力波被质疑是好事?诺奖得主破争议,分享成功心得 | 科技袁人

- 《穿越土星环》是一部怎样的硬核科幻?何以摘取中国科幻最高奖?

- 为了一滴沥青,竟熬死两代科学家,好在得了一个搞笑诺贝尔奖

- 新型冠状疫情手抄报,新冠疫情手抄报一等奖?

- Shopee泰国站点3月营销工具设置奖励怎么做?

- 点淘app女王节主播/商家短视频活动奖励及发放

- 新型病毒手抄报简单,新冠疫情手抄报一等奖?

- 玩手机软件可以得到什么,可以免费抽奖领手机的app?

- 综合评价招生对高考成绩和奖项有何要求?如何在个人陈述和面试环节脱颖而出?攻略来了!

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。